前言

在高性能计算(HPC)和人工智能(AI)工作负载日益复杂的今天,如何高效地管理计算资源、提升用户生产力并降低系统管理成本,是每一个 IT 架构师面临的挑战。

本系列文章将基于 IBM Spectrum LSF Suite 的官方最佳实践指南,为您拆解从架构设计、安装部署到性能调优的全流程实战经验。作为开篇,我们将首先深入了解 LSF Suite 的架构全景及其针对现代工作负载(如 AI 和容器化应用)的核心能力。

什么是 IBM Spectrum LSF Suite?

IBM Spectrum LSF Suite 是一套重新定义了集群虚拟化和工作负载管理的集成解决方案。它并非单一的调度软件,而是一个紧密集成的套件,旨在为关键任务型的 HPC 和 AI 环境提供支持。

版本选择

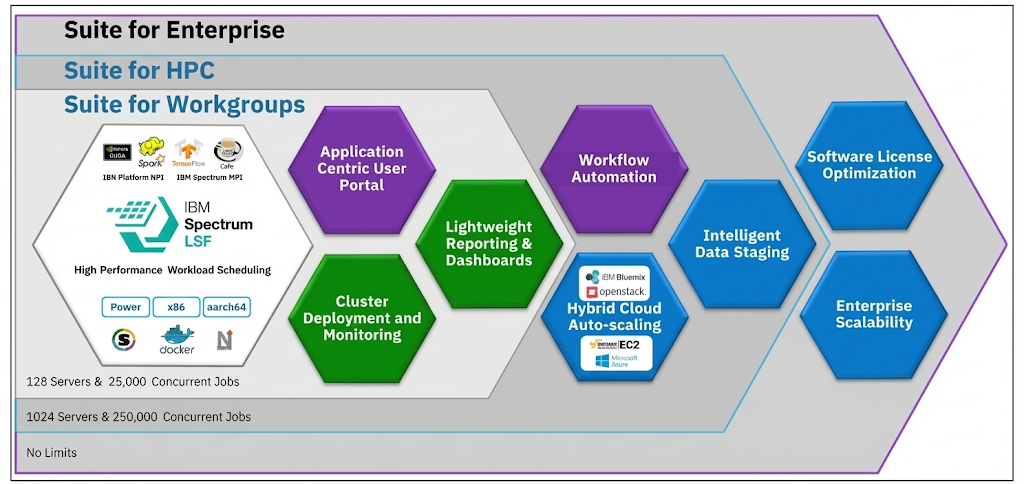

根据规模和需求的不同,LSF Suite 提供了三种配置版本:

| 版本 | 适用场景 |

|---|---|

| Suite for Workgroups | 小型工作组 |

| Suite for HPC | 中大型 HPC 集群(本文重点) |

| Suite for Enterprise | 企业级大规模部署 |

此外,还有一个免费的 Community Edition(社区版),支持最多 10 台服务器,供小规模测试使用。

核心目标

该套件的核心目标可以归纳为三点:

- 加速工作负载:通过基于策略的高级调度,最大化利用计算环境

- 提高生产力:通过增强的用户界面和自动化策略,让用户无需成为集群专家即可专注于科研或业务成果

- 简化管理:利用 Ansible 等工具,通常可以在一小时内完成全功能集群的部署

核心能力:为 AI 与混合云而生

经过 25 年的客户驱动型增强,LSF Suite 已经发展成为一个功能完备的调度器。以下是其在现代计算环境中的几个关键能力:

1. 强大的 GPU 调度能力

对于 AI 训练和推理任务,GPU 是核心资源。LSF 提供了无与伦比的 GPU 工作负载管理能力:

- 自动化管理:支持 GPU 的自动检测和配置

- 深度集成:与 NVIDIA MPS(多进程服务)和 DCGM(数据中心 GPU 管理器)集成,能够精细化地管理电源和性能,完美赋能 HPC 和 AI 工作负载

1

2

3

4

5

6

7

8

9

10

11

┌─────────────────────────────────────────────────────────┐

│ LSF GPU 调度架构 │

├─────────────────────────────────────────────────────────┤

│ 用户作业 ───→ bsub -R "ngpus=4" ./train.py │

│ ↓ │

│ LSF Core ───→ 检测可用 GPU 资源 │

│ ↓ │

│ NVIDIA 集成 ───→ MPS / DCGM 精细化管理 │

│ ↓ │

│ 执行节点 ───→ GPU 隔离 + 监控 │

└─────────────────────────────────────────────────────────┘

2. 原生容器支持

LSF 原生支持 Docker、Singularity、Shifter 等主流容器技术。这意味着容器化的 HPC 和 AI 应用可以像传统作业一样在 LSF 中运行。

安全性增强

LSF 与 Docker 紧密集成,能够处理所有特权操作。用户不需要加入 Docker 用户组即可提交容器作业,大大降低了安全风险。

镜像亲和性 (Image Affinity)

在 Service Pack 9 中,LSF 引入了镜像亲和性概念:

由于 HPC/AI 容器镜像通常以 GB 计,下载耗时且占用磁盘。开启此功能后,LSF 会尝试重用节点上已有的镜像,消除了重复下载的开销。

1

2

3

4

5

6

7

# 示例:提交 Docker 容器作业

bsub -app docker -Is /bin/bash

# LSF 自动处理:

# 1. 检查目标节点是否已有镜像

# 2. 优先调度到已有镜像的节点

# 3. 避免重复下载 GB 级镜像

3. Kubernetes 集成

随着云原生技术的普及,LSF 增强了与 Kubernetes 的协作。LSF 可以作为一个中心化的通用调度器,管理 LSF 和 Kubernetes 环境。

这使得 LSF 丰富的调度策略(如公平共享、优先级等)可以应用于 Kubernetes Pod 的放置,实现两种工作负载的共存:

| 工作负载类型 | 调度器 | 策略支持 |

|---|---|---|

| HPC 作业 | LSF | 公平共享、优先级、抢占 |

| AI 训练 | LSF | GPU 分配、队列管理 |

| 微服务 | Kubernetes + LSF | Pod 放置、资源配额 |

4. 混合云突发 (Hybrid Cloud Bursting)

当本地资源不足时,LSF 支持通过 Resource Connector 功能将工作负载”突发”到云端。

支持的云平台

- AWS

- Azure

- Google Cloud (GCE)

- IBM Cloud

- OpenStack

自动伸缩

LSF 可以根据负载自动请求云端资源,并在负载下降后释放机器,确保成本效益:

1

2

3

4

5

6

7

8

9

10

11

本地集群满载

↓

LSF 检测到排队作业

↓

Resource Connector 启动云端实例

↓

作业在云端执行

↓

负载下降后自动释放云资源

↓

成本最优化

Azure CycleCloud 支持

Service Pack 9 新增了对 Azure CycleCloud 的官方支持,提供了更具扩展性的 Azure 资源请求接口。

5. 应用中心 (Web Portal)

LSF 提供了一个以应用为中心的 Web 门户,通过向导和表单引导用户提交作业,显著降低了学习成本和提交错误率。

内置模板支持

系统内置了针对以下应用的作业提交模板:

| 应用类型 | 模板功能 |

|---|---|

| TensorFlow | 分布式训练配置 |

| Jupyter Notebooks | 交互式会话管理 |

| H2O.ai | AutoML 作业提交 |

这些模板简化了复杂 AI 任务的运行流程,用户无需记忆复杂的命令行参数。

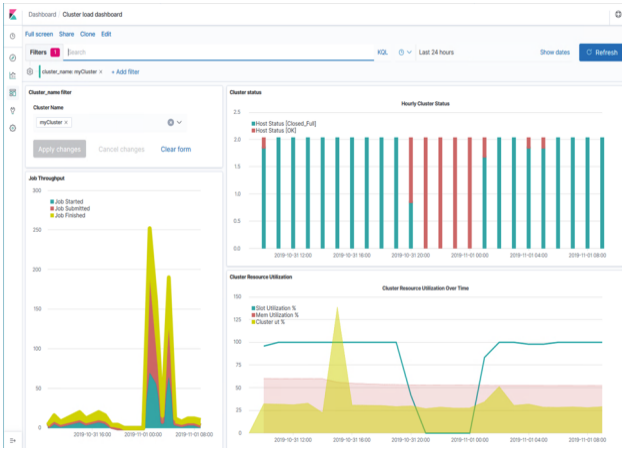

监控与报告

为了更好地洞察集群状态,LSF Suite 提供了强大的报告功能:

IBM Spectrum LSF Explorer

提供原生的图表功能,用于生成简单的报告和可视化。

Kibana 集成

对于需要处理大量数据或进行复杂可视化的场景,LSF Suite 支持安装 Kibana(基于 ELK 栈)。这使得管理员可以构建实时监控仪表盘:

- 集群负载趋势

- 吞吐量统计

- 资源利用率分析

- 作业等待时间分布

总结

IBM Spectrum LSF Suite 作为一个成熟的工作负载管理平台,其核心能力可以总结为:

| 能力领域 | 关键特性 |

|---|---|

| GPU 调度 | 自动检测、NVIDIA MPS/DCGM 集成 |

| 容器支持 | Docker/Singularity/Shifter、镜像亲和性 |

| 云集成 | AWS/Azure/GCE/IBM Cloud/OpenStack 突发 |

| Kubernetes | 统一调度、策略共享 |

| 用户体验 | Web Portal、应用模板 |

| 监控 | LSF Explorer、Kibana 集成 |

下期预告:

了解了架构和核心能力后,如何从零开始搭建一套高可用的 LSF 环境?在下一篇文章《IBM Spectrum LSF Suite 最佳实践 (2):高可用数据库配置与网络规划避坑指南》中,我们将深入技术细节,手把手教您配置 MariaDB Galera 集群以及处理复杂的多网络环境。敬请期待!